Inhalt

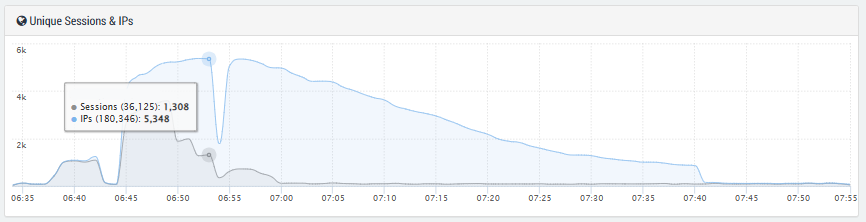

Im Monitoring-Dashboard erschien ein Muster, das eine klassische DDoS-Attacke zeigte. Eine Handelsplattform war das Ziel massiver Web-Anfragen: Es gab zwei deutliche Traffic-Spitzen in kurzer zeitlicher Folge, die beide groß genug waren, um eine ungeschützte Website in die Knie zu zwingen. Wir schauen uns die größere Traffic-Spitze genauer an.

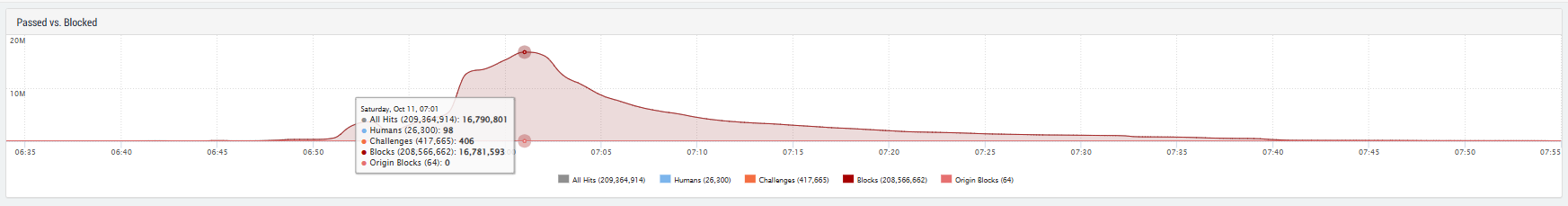

Die gemessenen Spitzenwerte betrugen rund 16 Millionen Requests pro Minute bei einer Bandbreite von 160 Gigabis pro Minute, also etwa 21 Gbit/s. Die Anfragen konnten erfolgreich abgewehrt werden. Das Angriffsmuster offenbart jedoch, wie professionell organisierte Botnetze inzwischen agieren und welche Rolle scheinbar kleine Details, wie der User Agent, spielen.

Kein Blitzangriff, sondern kalkuliertes Hochfahren

Der Traffic stieg nicht explosionsartig an, sondern folgte einer charakteristischen Kurve, langsam und stetig über mehrere Minuten hinweg. Diese kontrollierte Eskalation ist typisch für Akteure, die ihre Ziele zunächst testen, um beispielsweise herauszufinden, ob eine Seite durch Mitigation-Systeme geschützt ist.

Solche „weichen” Starts sind raffinierter, als sie wirken: Ein plötzlicher Peak fällt auf, ein langsamer Anstieg kann jedoch Systeme täuschen, die nur auf abrupte Volumensprünge reagieren. Die Angriffsdauer betrug insgesamt weniger als eine halbe Stunde.

Ein Botnetz, das einmal um die Welt reicht

Die Quell-IP-Adressen waren auf dem gesamten Globus verteilt: Indonesien, die USA, China, Deutschland, Indien, Mexiko, Brasilien, Peru und Russland. Mehr als 5.000 Unique IPs waren beteiligt.

Dieses breite Spektrum spricht für ein groß angelegtes, gut organisiertes Botnetz. Offensichtlich wurden teilweise Cloud-Ressourcen oder leistungsstarke Server genutzt, was an dem hohen Datendurchsatz pro Host erkennbar war. Besonders auffällig war, dass ein erheblicher Anteil der Requests aus Netzen großer Telekommunikationsanbieter kam. Dies deutet auf kompromittierte Geräte oder Server innerhalb normaler Consumer-Netze hin, was ein klassisches Kennzeichen moderner, „gemischter“ Botnets ist.

Angriff auf die Root-Domain

Die Angreifer fokussierten sich bei ihrem Angriff auf die gesamte Website, d. h. auf die Root-Domain, also die Startseite, den zentralen Einstiegspunkt. Damit sollte die gesamte Webpräsenz offenbar unzugänglich gemacht werden.

Die Abwehrsysteme reagierten effizient: Auffällige IPs wurden automatisch in eine Quarantäne-Zone verschoben und sofort geblockt. So konnten Ressourcen geschont und die Latenz niedrig gehalten werden. Die meisten Anfragen erhielten eine HTTP-403-Antwort. Das zeigt, dass die Abwehr auf Applikationsebene konsequent griff.

Wenn der User Agent zur Signatur wird

Eines der Merkmale dieser Attacke war die Gleichförmigkeit der sogenannten User Agents, also der Kennungen, die Browser an Server senden, um sich beispielsweise als „Chrome“, „Safari“ oder „Firefox“ auszugeben.

Im beobachteten Angriff verwendeten fast alle Requests denselben User-Agent-String, ein klares Alarmsignal:

- Reale Nutzer:innen verwenden unterschiedlichste Browser, Versionen und Geräte – also viele verschiedene User Agents.

- Wenn hingegen Tausende IPs mit demselben User Agent auftreten, ist das ein Hinweis auf automatisierte Requests, etwa aus einem Botnetz oder Skript.

- Moderne Schutzsysteme erkennen solche Muster und blocken identische User Agents, wenn sie von vielen Quellen gleichzeitig kommen.

Getarnte Angriffe variieren User Agents dynamisch

Heute können Angreifer problemlos Listen mit Tausenden realistisch wirkenden User-Agent-Strings generieren, von denen viele öffentlich abrufbar sind. In einer fortgeschrittenen Angriffsversion würde jeder Bot einen anderen, plausiblen User-Agent-String verwenden. Dadurch wird es schwieriger, Traffic anhand dieser Signatur zu identifizieren oder zu blockieren.

Der beobachtete Angriff hingegen blieb bei zwei statischen User Agents und scheiterte somit an der ersten Verteidigungslinie.

Warum Gleichförmigkeit hilft, aber auch gefährlich ist

Für Verteidiger ist eine solche Gleichförmigkeit ein Glücksfall: Einfache Regeln wie „Blockiere alle identischen User Agents bei mehr als X Anfragen pro Minute aus verschiedenen IPs“ funktionieren zuverlässig.

Doch die Szene lernt schnell. Bereits heute kursieren Botnet-Frameworks, die mit randomisierten Browser-Signaturen, gefälschten Headern oder sogar simulierten Mausbewegungen arbeiten, um wie echte Nutzer zu wirken.

Damit wandelt sich der User Agent vom simplen Erkennungsmerkmal zu einem der wichtigsten Indikatoren für Bot-Intelligenz.

Erfahren Sie mehr über eine DSGVO-konforme, cloud-basierte und patentierte DDoS Protection, die hält, was sie verspricht.

Rebalancing während des Angriffs

In den Traffic-Grafiken waren kurze Pausen oder Einbrüche im Datenvolumen zu erkennen. Wahrscheinlich wurde in diesen Momenten das Botnetz umstrukturiert. Entweder blockten Provider auffällige IPs, Geräte verloren die Verbindung oder die Angreifer wechselten zu neuen Adressbereichen.

Diese Dynamik unterstreicht, dass es sich um eine hochautomatisierte Infrastruktur handelt. Botnetzbetreiber erkennen in Echtzeit, welche Teile blockiert wurden, und ersetzen sie automatisch durch neue Ressourcen. Das erfordert technische Kontrolle und Ressourcen. Hier waren keine „Script Kiddies” am Werk, sondern es handelte sich um einen koordinierten Angriff mit globalem Zugriff.

Was können Unternehmen aus diesem Beispiel lernen?

Dieser Angriff mag im Vergleich zu komplexen Zero-Day-Exploits harmlos wirken, doch er zeigt eindrucksvoll: Auch einfache Mechanismen, die global skaliert und automatisiert sind, können erhebliche Störungen verursachen.

Für Betreiber von Webplattformen bedeutet das:

- Bot-Management ist Pflicht, keine Kür. Nur wer automatisierte Zugriffe intelligent erkennt, kann Traffic sauber trennen und Ressourcen schützen.

- User-Agent-Analysen liefern wertvolle Frühwarnsignale. Gleichförmige Browser-Kennungen über viele IPs hinweg sind ein sicheres Indiz für Automation.

- Quarantäne- und Rate-Limit-Regeln verhindern Ressourcenverschwendung. Verdächtige IPs sollten frühzeitig aus dem Verkehr gezogen werden.

- Forensische Daten sichern. Kurze Packet Captures und Log-Ausschnitte helfen dabei, Muster zu analysieren und Angriffspfade nachzuvollziehen.

- Cloud-Provider im Blick behalten. Da viele Angriffe virtuelle Maschinen in Public Clouds ausnutzen, ist ein gezieltes Monitoring wichtig, um Missbrauch früh zu erkennen.

Der unterschätzte Verbündete: der User Agent

Was wie ein klassischer DDoS-Angriff begann, entpuppte sich als Lehrstück über Automatisierung, Wiederverwendbarkeit und Identität im Netz. Der User Agent, der oft übersehen oder ignoriert wird, war in diesem Fall der Schlüssel zum Verständnis und zur erfolgreichen Abwehr.

Er zeigte, dass hinter Millionen von Requests kein organisches Nutzerverhalten steckte, sondern ein global synchronisiertes Botnetz. Sicherheit im Internet hängt nicht nur von der Bandbreite oder der Hardware ab, sondern auch von künstlicher Intelligenz, Mustererkennung und dem kontinuierlichen Lernen der Abwehrsysteme.

Sind Ihre Schutzsysteme bereit für die nächste Welle?

Wir unterstützen Unternehmen dabei, Botnet-Traffic zuverlässig zu erkennen, User-Agent-basierte Erkennungsmechanismen zu verfeinern und flexible Abwehrstrategien zu entwickeln.

Kontaktieren Sie uns für eine unverbindliche Sicherheitsanalyse, bevor der nächste Spike eintritt.